前言:提高搜索引擎对网站的抓取质量,从以下两个文件入手:

- sitemap文件

- Robots.txt

sitemap

sitemap是一种包含网站所有页面URL的文件,有助于搜索引擎更快地索引和发现您的网站,其格式有xml或txt。在Hexo中,可以利用hexo-generator-sitemap插件生成sitemap文件。

基本使用

npm i hexo-generator-sitemap --save

参数配置,具体使用参考文档:https://github.com/hexojs/hexo-generator-sitemap/tree/master?tab=readme-ov-file#options

sitemap:

path: sitemap.xml

tags: false

categories: false

template: ./template/sitemap.xml

生成后的sitemap文件如下:

<?xml version="1.0" encoding="UTF-8"?>

<urlset xmlns="http://www.sitemaps.org/schemas/sitemap/0.9">

<url>

<loc>https://www.wztlink1013.com/blog/tttk33/</loc>

<lastmod>2024-01-14</lastmod>

<changefreq>weekly</changefreq>

<priority>0.8</priority>

</url>

<url>

<loc>https://www.wztlink1013.com/</loc>

<lastmod>2024-01-14</lastmod>

<changefreq>daily</changefreq>

<priority>1.0</priority>

</url>

</urlset>

- loc:抓取的网站子页url

- lastmod:改子页最新一次更新时间

- changefreq:改子页更新频率

- priority:在该站点的抓取优先级权重

自定义生成模板

在项目根路径创建template/sitemap.xml文件,并写入下面代码

<?xml version="1.0" encoding="UTF-8"?>

<urlset xmlns="http://www.sitemaps.org/schemas/sitemap/0.9">

{% for post in posts %}

<url>

<loc>{{ post.permalink | uriencode }}</loc>{% if post.updated %}

<lastmod>{{ post.updated | formatDate }}</lastmod>{% elif post.date %}

<lastmod>{{ post.date | formatDate }}</lastmod>{% endif %}

<changefreq>weekly</changefreq>

<priority>0.8</priority>

</url>

{% endfor %}

<url>

<loc>{{ config.url | uriencode }}</loc>

<lastmod>{{ sNow | formatDate }}</lastmod>

<changefreq>daily</changefreq>

<priority>1.0</priority>

</url>

{% for tag in tags %}

<url>

<loc>{{ tag.permalink | uriencode }}</loc>

<lastmod>{{ sNow | formatDate }}</lastmod>

<changefreq>weekly</changefreq>

<priority>0.2</priority>

</url>

{% endfor %}

{% for cat in categories %}

<url>

<loc>{{ cat.permalink | uriencode }}</loc>

<lastmod>{{ sNow | formatDate }}</lastmod>

<changefreq>weekly</changefreq>

<priority>0.2</priority>

</url>

{% endfor %}

</urlset>

指定页面跳过sitemap收录

在hexo中的文章或是页面,可以如下配置:

---

title: 隐藏文章

date: 2024-01-14

sitemap: false

---

robots.txt

robots文件是一个文本文件,用于向搜索引擎指示哪些页面可以访问和索引,哪些页面应该被忽略。通过优化 robots文件,可以提高网站在搜索引擎中的排名和曝光度。

# https://www.wztlink1013.com

User-agent: *

Disallow: /

Sitemap: https://www.wztlink1013.com/sitemap.xml

- User-agent:* 表示允许所有搜索引擎访问您的网站,如果限定的话,则键入

[搜索引擎名称] - Sitemap:说明sitemap文件url

- Disallow:

/表示禁止该搜索引擎访问您的网站中所有页面和文件

- 检测自己写的robots文件是否生效:https://ziyuan.baidu.com/robots/intro

- 语法规则:https://ziyuan.baidu.com/college/courseinfo?id=267&page=13

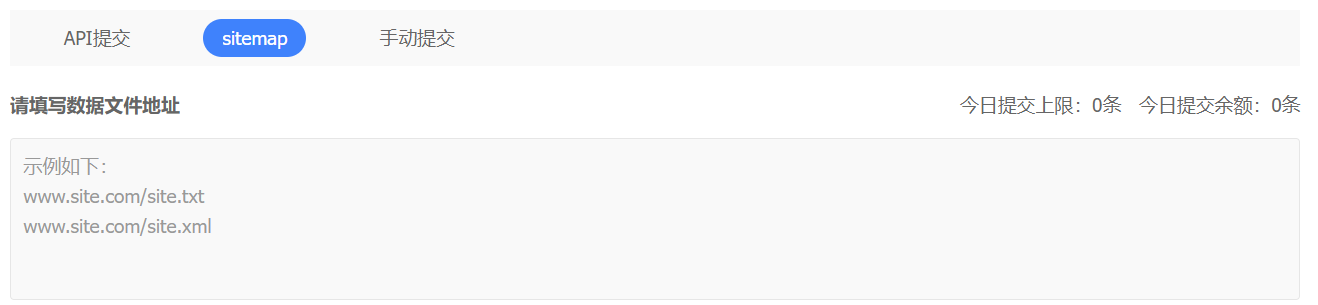

❗百度不再允许大多数站点提交sitemap文件

如果之前没有提交过sitemap链接的,貌似没有办法提交sitemap链接了,如果之前提交过应该不受影响。。。

评论区